注意看,这个机器人对抗人类的视频,在网上彻底火了。

那叫一个拳拳到肉,刺激程度引得围观群众大呼鹅妹子嘤。

好消息是,这个机器人并非真实存在。

但另一个不知道是好还是坏的消息是,这样的特效,是AI一键合成的。

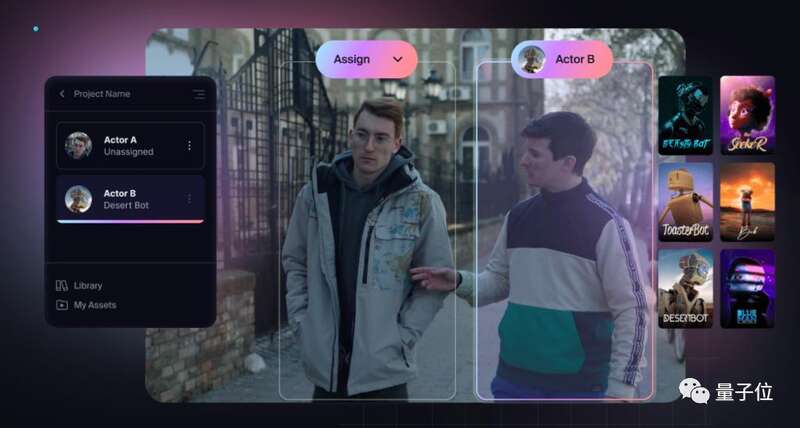

就是说,从左边这样的人类实拍,到右边这样的特效画面,人类需要做的,只是用鼠标把模型拖到画面里。

这个AI神器,名叫Wonder Studio AI。

刚发宣传片时,就曾引发wo cao声一片。

现在内测名额开始发放,网友们上手一玩,更是停不下来,直接在社交媒体上刷了屏。

比如随手来一段比波士顿动力还动感流畅的男团热舞。

或者在自个儿屋里来段freestyle。

↑↑↑这个作品的作者还透露,这是一个原本需要三天完成的视觉特效镜头,现在只需要1分钟。

也难怪网友们坐不住了。

无需动捕设备,一键生成CG动画

有关Wonder Studio,官方的说法是,“一种可自动为CG角色制作动画、打光,并将其合成到真实场景中的AI工具”。

按照官网说明,对于用户来说,在CG动画制作阶段,你不再需要复杂的3D软件,也不需要昂贵的动捕硬件。

只需一台用来拍摄的相机,拍好视频后丢进Wonder Studio处理,就足以以假乱真。

具体步骤是这样的:

首先用相机拍摄一段视频,视频中,真人演员可以随意做出任何动作;

将MP4或MOV等格式的视频导入Wonder Studio,并选定需要处理的视频段落,拖入中间区域等待处理;

点击菜单栏的next按钮,AI开始识别和分析视频中的人物;

选中右侧选项栏中所需要的CG模型,拖拽至需要替换的人物区域;

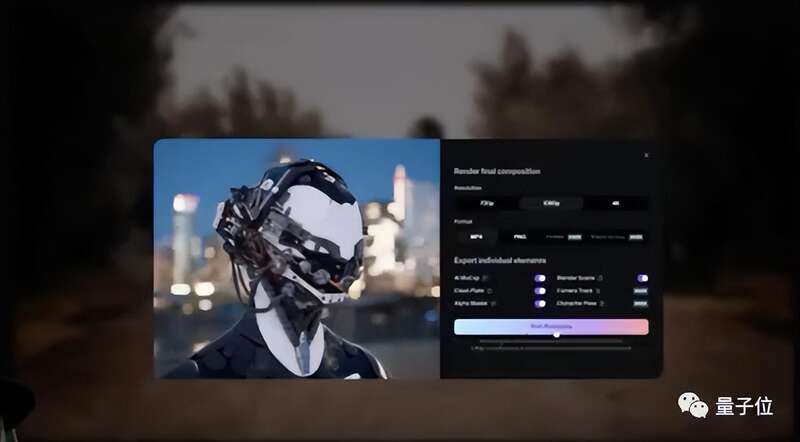

这时候会跳出一个小框,能够根据需要调整HDR打光、画质清晰度、视频格式等。

最后,选择解算生成,就能完成视频段落中CG模型对真人演员的替换。

对于专业人士来说,除了最终成品,Wonder Studio还能导出新视频的不同轨道,包括动作捕捉、摄像机跟踪和空镜等等。

面对需要修改的细节,也可以直接上手微调。

传统的CG制作流程,需要移除原有人物、把需要替换的CG元素导入引擎或Blender等软件当中、根据相机解算结果进行合成、匹配灯光、渲染……最终把新的CG模型放到视频场景中。

比较而言,用上Wonder Studio后简化了很多工序,也难怪很多人评论,如果这个工作流跑通,是十分利好小成本影视制作的。

不过,Wonder Studio并非十全十美。

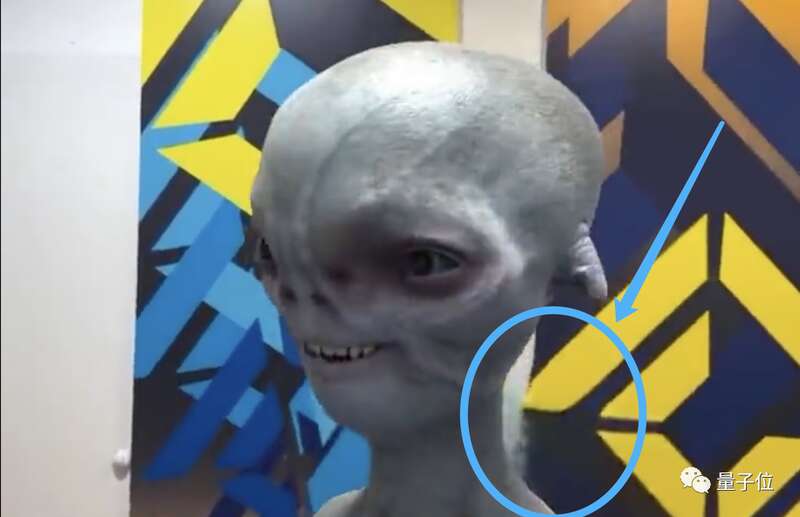

主要体现在CG模型覆盖原人物后,CG角色和背景衔接处处理不算优秀。

比如会出现美颜瘦脸特效开太大,以至于脸部周围背景扭曲的情况:

而且,CG模型的边缘像素会被拉伸,原人物的衣物等不能做到100%消除和被覆盖:

开头展示的爆火视频中,其实也有不少穿帮镜头。

所以,虽然效果强大操作简单,目前而言,Wonder Studio还是不能单独放到实际项目中使用,否则一眼惊艳,再看露馅。

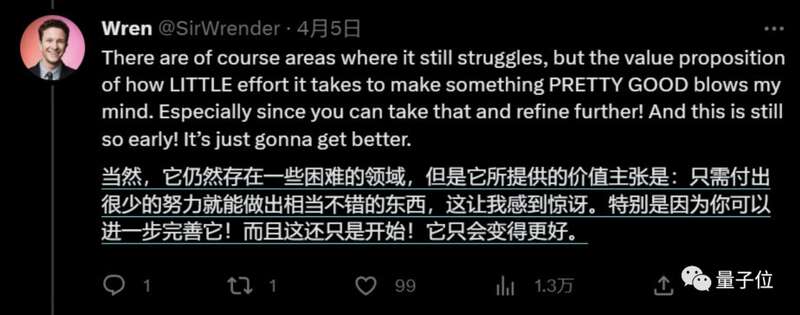

但其展示的潜能,已经得到内测网友的盖章肯定。

有内测网友反馈,在他的几次测试中,Wonder Studio能够自动化80%的视觉特效工作。

它仍存在一些困难的领域,但它提供的价值主张是,只需要付出很少的努力就能做出相当不错的东西。

而且这只是开始!它还会变得更好!

《头号玩家》男主创业项目

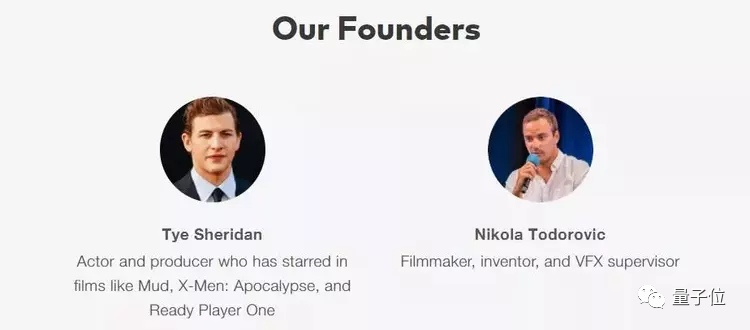

有意思的不止是产品,Wonder Studio背后的公司,也颇有故事。

它的出品方是一家名叫Wonder Dynamics的AI初创公司,致力于通过AI提高电影制作的效率和质量。

截至目前,公司在种子轮和A轮一共募集了1150万美元融资。

Wonder Studio是他们筹备3年后,推出的一款基于AI的在线视频特效处理平台。

公司已经表示,Wonder Studio后续还将继续简化动作捕捉和渲染环节,继续提高制作效率。而且在公司的设想中,创作者在将来还能在系统自由上传自己的3D模型。

再来看公司创始团队,不少人是熟面孔。

比如世界闻名的导演斯皮尔伯格,就是这家公司的顾问。

而公司创始人之一,是《头号玩家》男主演泰尔·谢里丹。

(不知道是说男主“干一行爱一行”好呢,还是说他“积极致力于用AI抢自己饭碗”好,

)

还有消息称,美国导演组合罗素兄弟正在拍摄的一部电影中,Wonder Studio已经参与了部分制作环节。电影主角是《怪奇物语》主演Millie Bobby Brown和《银河护卫队》中星爵的扮演者Chris Pratt,电影将上线Netflix。

期待电影之前,更值得关注的一点是,最近这段时间,AI力量对视觉领域疯狂下手了。

这就不得不提到近日在科技圈疯狂刷屏的Meta大杀器,Segment Anything Model (SAM)。

该模型惊艳世人的能力,就是能够识别和分离图像及视频中的特定对象。使用SAM,用户可以通过单击或输入文字,来选中需要编辑的任何物体。

Meta在介绍SAM时写道:

SAM 已经学会了关于物体的一般概念,并且,它还可以为任何图像,或视频中的任何物体生成msak,包括训练集中不包含的类型。

SAM足够通用,且在新的图像领域无需额外训练,达到即开即用。

这种零样本迁移的能力,正是GPT-4能力惊人的重要原因之一。因此,国内外不少媒体称SAM的发布为CV领域的ChatGPT时刻。

目前,SAM已经开源,并进一步提供了其10亿掩码数据集的完整细节,

Meta官方的说法是,随着技术发展,SAM可以成为AR、VR等更通用系统的强大组件。

联想到今天介绍的Wonder Studio,接入SAM能力后,对原有人类图像的分割,是不是就不再会出现裙角被遗漏的情况了?